La désinformation : un effet de réseau ?

Clement Couderc, Stephane Iovleff

De nos jours, les fakes news sont devenus un des sujets de société les plus discutés. Détecter et défaire les fake news est devenu une tâche difficile face à la quantité grandissante d’informations se répandant sur internet. Selon les estimations de l’association de journalistes Newsguard, le nombre d’informations douteuses auxquelles les Américains auraient été confrontés aurait doublé entre 2020 et 20191. Ce combat peut-il vraiment être gagné ? Est-ce que la structure même des réseaux n’explique pas le phénomène ?

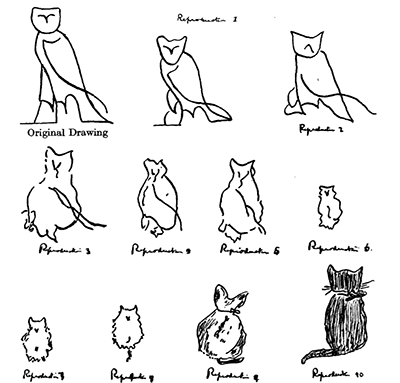

Dès 1932, le psychologue Frederic Bartlett a mis en lumière l’inévitable déformation de l’information lorsqu’elle circule entre plusieurs individus par voie orale2. Au travers de différentes expériences sur la mémoire, le chercheur britannique démontre l’existence du phénomène de « distorsion ». Les expériences consistent en une variante du jeu du « téléphone arabe » utilisant des dessins. Une personne reçoit un dessin qu’elle doit à son tour reproduire avant de le passer à la personne suivante. Les résultats de ces expériences montrent que la mémorisation des dessins est fortement influencée par le contexte social, se traduisant alors en une déformation dans leurs reproductions. Ainsi, par exemple, si on donne à reproduire à des participants occidentaux, un hiéroglyphe égyptien de chouette, sans évidemment leur indiquer de quoi il s’agit, le hiéroglyphe va au fur et à mesure des reproductions, se transformer en un dessin de chat. Depuis l’expérience a été répliquée avec plus ou moins de succès3, toutefois Bartlett est aujourd’hui considéré comme pionnier de la psychologie cognitive et fondateur de la théorie des schémas cognitifs.

Plus récemment, les chercheurs Moussaïd, Brighton et Gaissmaier, ont montré dans une étude, qu’un message communiqué de bouche à oreille, est soumis à une déformation et peut perdre déjà la moitié de sa signification après être passé par trois personnes4. Dans cette expérience l’information portait sur la dangerosité d’un perturbateur endocrinien, le triclosan. Le propos était à l’origine neutre mais clairement sujet à polémique, certains participants ayant déjà un avis sur la question. On observe que la distorsion de l’information est biaisée. En effet, en faisant circuler l’information dans des chaînes d’individus partageant préalablement le même avis sur le triclosan, on observe une amplification de la déformation de l’idée en faveur ou en défaveur du produit. L’être humain est rempli de biais, et, lors de la transmission d’une information, il va inconsciemment la reformuler dans le sens de ses croyances.

La désinformation n’est évidemment pas un phénomène récent. Depuis le jour où des informations se sont mises à circuler, elles ont pu être soumises à des mauvaises interprétations ou des déformations. Cependant, aujourd’hui, avec internet, le problème se situe surtout dans la rapidité et l’ampleur avec laquelle elles se répandent sur les réseaux sociaux, cela change complètement la donne. Voyons comment l’étude des structures des réseaux peut nous permettre de comprendre et peut-être de combattre le phénomène.

La structure des réseaux

Avez-vous déjà entendu parler des « six degrés de séparation » de Milgram ? Il s’agit d’une théorie établie en 1929 par l’écrivain Hongrois Karinthy et expérimentée en 1967 par le célèbre psychologue américain Stanley Milgram5. Cette théorie avance que chaque personne dans le monde peut être reliée à une autre via une chaîne de relations sociales de six maillons ou moins. Avec les réseaux sociaux ce nombre est désormais calculable. Il a été mesuré à moins de 4 (3,74 précisément) maillons sur Facebook6. On comprend bien désormais pourquoi les informations peuvent se répandre à une vitesse folle à l’intérieur de ce genre de réseau.

Examinons un peu la structure d’un réseau de relation. La figure ci-contre est une représentation d’un réseau de relations entre utilisateurs Twitter comportant 2 406 nœuds. Il est en fait composé de tous les abonnements et abonnés de l’auteur du graph. La taille d’un nœud représente son importance en termes de relations au sein du réseau. Par ailleurs, plus un nœud possède de relations similaires à un autre, plus ils se situeront proches l’un de l’autre. On remarque alors naturellement l’apparition de communautés au sein du réseau, soulignées ici par les différentes couleurs.

Mais comment les informations circulent-elles dans une communauté ? Le sociologue Mark Granovetter développait dans sa thèse de 1973 : « The Strength of Weak Ties », la théorie selon laquelle les cercles sociaux sont gouvernés par des liens « faibles » et des liens « forts »7. Chaque individu entretiendrait des liaisons fortes avec les personnes de son entourage proche, tout en développant des liaisons faibles avec des individus de passage. On estime qu’un individu, avant l’ère des réseaux sociaux, avait entre 5 et 15 liaisons fortes, et jusqu’à 150 liaisons faibles. Cette dernière estimation provient du nombre de Dunbar, qui serait, selon la théorie de l’anthropologue éponyme, la limite cognitive du nombre d’individus avec lesquels une personne peut entretenir simultanément une relation stable8.

Ces liens faibles sont très utiles car ils permettent d’apporter de nouvelles informations au sein d’une communauté de liens forts. Avec les réseaux sociaux, il n’y a désormais plus de limite au nombre de liens faibles qu’un individu peut développer. Ce nombre explose très facilement puisqu’il suffit d’un clic pour ajouter une personne à son propre réseau. Et ce nombre est d’autant plus élevé sur un réseau comme Twitter où il y a nul besoin d’attendre l’acceptation d’un utilisateur pour suivre son contenu.

Le faux a-t-il une signature virale ?

Il se trouve, contrairement à ce que l’on pense, que l’immense majorité des informations partagées n’intéresse personne. Elles n’ont qu’une portée nulle ou petite : sur Twitter, 93% des informations ne sont repartagées par personne, 6,8% ne touchent quant à elle qu’une personne et ce n’est que les 0,2% restantes qui ont réellement une portée gigantesque. Elles sont alors celles qui sont le plus visible et on estime qu’une information sur deux vue sur internet viendrait de ces 0,2%.9

Les informations dans un réseau social circulent de manière à former une structure que l’on appelle une cascade de propagation, que l’on peut assimiler à une contagion. Cette cascade prend son origine lorsqu’un utilisateur partage une information, un tweet par exemple. Cette cascade va alors s’élargir lorsque le tweet atteint un plus grand nombre d’utilisateurs et s’allonger si l’un d’eux partage à nouveau ce tweet. Une équipe de chercheurs du MIT a publié en 2018 une étude sur la propagation des vraies et fausses informations sur internet. L’étude repose sur une analyse de 4,5 millions de tweets et retweets sur 126 000 sujets10. Il en résulte que les fausses informations se propagent plus vite et plus loin que les vraies informations et ce dans toutes les catégories !

L’effet est par ailleurs encore plus accentué en ce qui concerne les informations politiques. Les fausses informations ont 70% de chances en plus d’être partagées par rapport aux vraies. Autre fait intéressant, les chercheurs ont mis le doigt sur les partages effectués par des robots. Ils ont trouvé qu’ils amplifient tout autant la propagation des fausses que des vraies informations, révélant que la propagation plus importante des fakes news est due à de réelles personnes derrière leur machine. On apprend même que ce ne sont pas les gros comptes ou les influenceurs qui participent le plus à cette propagation, mais plutôt des comptes d’utilisateur lambda, ayant peu d’abonnés et peu d’abonnements.

Mais pourquoi les fake news bénéficient-elles d’une telle prime à la propagation ? Ni les caractéristiques des utilisateurs, ni la structure du réseau par elle-même n’expliquent ce phénomène. Une hypothèse, donnée par l’équipe de chercheur du MIT, est que les personnes sont attirées par les informations nouvelles : « Lorsque l’information est nouvelle, elle est non seulement surprenante, mais aussi plus précieuse, tant du point de vue de la théorie de l’information (dans le sens où elle constitue la meilleure aide à la prise de décision) que du point de vue social (dans la mesure où elle confère un statut social à celui qui est « au courant » ou qui a accès à des informations « privilégiées » uniques).

Comment les plateformes peuvent-elles lutter… contre les effets de leur propre structure ?

Si les plateformes s’engagent dans la lutte contre la désinformation et la propagation des fake news depuis plusieurs années, force est de constater que les résultats sont limités. Il suffit de naviguer en quelques clics sur les hashtags en tendances pour s’en convaincre.

Les modérateurs de contenus, employés par les plateformes, se retrouvent eux aussi complètement dépassés par le flux énorme d’informations. Ils font face chaque jour au pire de ce que l’on peut trouver sur internet, tandis que les IA peinent toujours à détecter et supprimer les contenus violents11. Les modérateurs, souvent employés par des sociétés tiers, sortent du silence et témoignent sur leurs horribles conditions de travail depuis maintenant plusieurs années, en faisant fi des clauses de non-divulgation. Pire, dans de nombreux pays la modération est complétement absente, et où elle est présente, elle se concentre essentiellement sur les contenus de terrorisme islamique plutôt que de traiter toutes les formes de violence politique, de terrorisme et d’extrémisme12.

Pourrions-nous utiliser les structures de propagation pour détecter les fake news plutôt que l’analyse de contenu ? En 2020, des chercheurs ont utilisé les signatures de propagations, mises en lumière dans l’étude du MIT, pour débusquer des fake news avec une précision de 87%13. Ainsi, pour mieux les détecter, il est maintenant plus intéressant d’étudier la structure de leur propagation plutôt que leur auteur ou leur contenu. Dans la même ligne, le professeur et journaliste pour The Atlantic, Ian Bogost, propose quant à lui, dans son article « People Aren’t Meant to Talk This Much »14, de restreindre les contacts sur les réseaux sociaux à un nombre adapté à ce qu’un être humain peut soutenir dans la vie réelle, comme par le passé. Il s’agit littéralement de fixer une limite au nombre de liens faibles, pour reprendre les idées de Granovetter. Limiter la portée et donc le nombre de personnes pouvant voir une publication ou limiter le temps de diffusion de celui-ci pourrait être une solution pour permettre aux utilisateurs de mieux évaluer la qualité des informations qu’ils font circuler et échapper à la surcharge cognitive.

Il est cependant évident que ce genre d’initiative serait contraire à l’intérêt des grandes compagnies du numérique. Leur business model repose, en effet, essentiellement sur la maximisation du temps passé par les utilisateurs sur leur plateforme, dans le but d’afficher un maximum d’annonces publicitaires. De ce point de vue, les fake news sont un vecteur utile d’engagement. Mais à quel prix pour les utilisateurs et la société toute entière ? Le jeu des réseaux sociaux en vaut-il la chandelle ? Pouvons-nous imaginer d’autres structures de propagation, qui amélioreraient la qualité des informations partagées, sans tomber dans des formes de censure ?

- McDonald K., « Special Report: 2020 Engagement Analysis », NewsGuard, dec. 2020, (https://www.newsguardtech.com/special-reports/special-report-2020-engagement-analysis)

- Bartlett F. C., « Remembering: A study in experimental and social psychology », Cambridge University Press, 1932

- Carbon C. et Albrecht S., « Bartlett’s schema theory: The unreplicated « portrait d’homme » series from 1932 », Quarterly Journal of Experimental Psychology, sep. 2012, (https://www.researchgate.net/publication/230847439_Bartlett’s_schema_theory_The_unreplicated_portrait_d’homme_series_from_1932)

- Moussaïd M., Brighton H. et Gaissmaier W., « The amplification of risk in experimental diffusion chains », Proceedings of the National Academy of Sciences, 20 avr. 2015

- Travers et Milgram, « An Experimental Study of the Small World Problem », Sociometry, 1969

- Backstrom L., Boldi P., Rosa M., Ugander J. et Vigna S., « Four degrees of separation », Proceedings of the 3rd Annual ACM Web Science Conference on – WebSci ’12, 2012

- Granovetter Mark S., « The strength of weak ties », American journal of sociology, 1973

- Krotoski A., « Robin Dunbar: we can only ever have 150 friends at most… », The Guardian, 14 mar. 2010, (https://www.theguardian.com/technology/2010/mar/14/my-bright-idea-robin-dunbar)

- Goel S., Anderson A., Hofman J. et Watts D. J., « The Structural Virality of Online Diffusion », Management Science, 2015

- Vosoughi S., Roy D. et Aral S., « The spread of true and false news online », Science, 9 mar. 2018, (https://www.science.org/doi/full/10.1126/science.aap9559)

- Marantz A., « Why Facebook Can’t Fix Itself », The New Yorker, 12 oct. 2020, (https://www.newyorker.com/magazine/2020/10/19/why-facebook-cant-fix-itself)

- Panday J., « Why Facebook Can’t Fix Itself », Internet Governance Project, 23 dec. 2020, (https://www.internetgovernance.org/2020/12/23/exploring-the-problems-of-content-moderation-on-social-media/)

- Meyers M., Weiss G., Spanakis G., « Fake News Detection on Twitter Using Propagation Structures », dans : van Duijn M., Preuss M., Spaiser V., Takes F., Verberne S. (eds), Disinformation in Open Online Media, MISDOOM, 2020

- Bogost I., « People Aren’t Meant to Talk This Much », The Atlantic, 22 oct. 2021, (https://www.theatlantic.com/technology/archive/2021/10/fix-facebook-making-it-more-like-google/620456/)